"¿Las inteligencias artificiales tienen derechos?" transcripción de Ernesto Castro

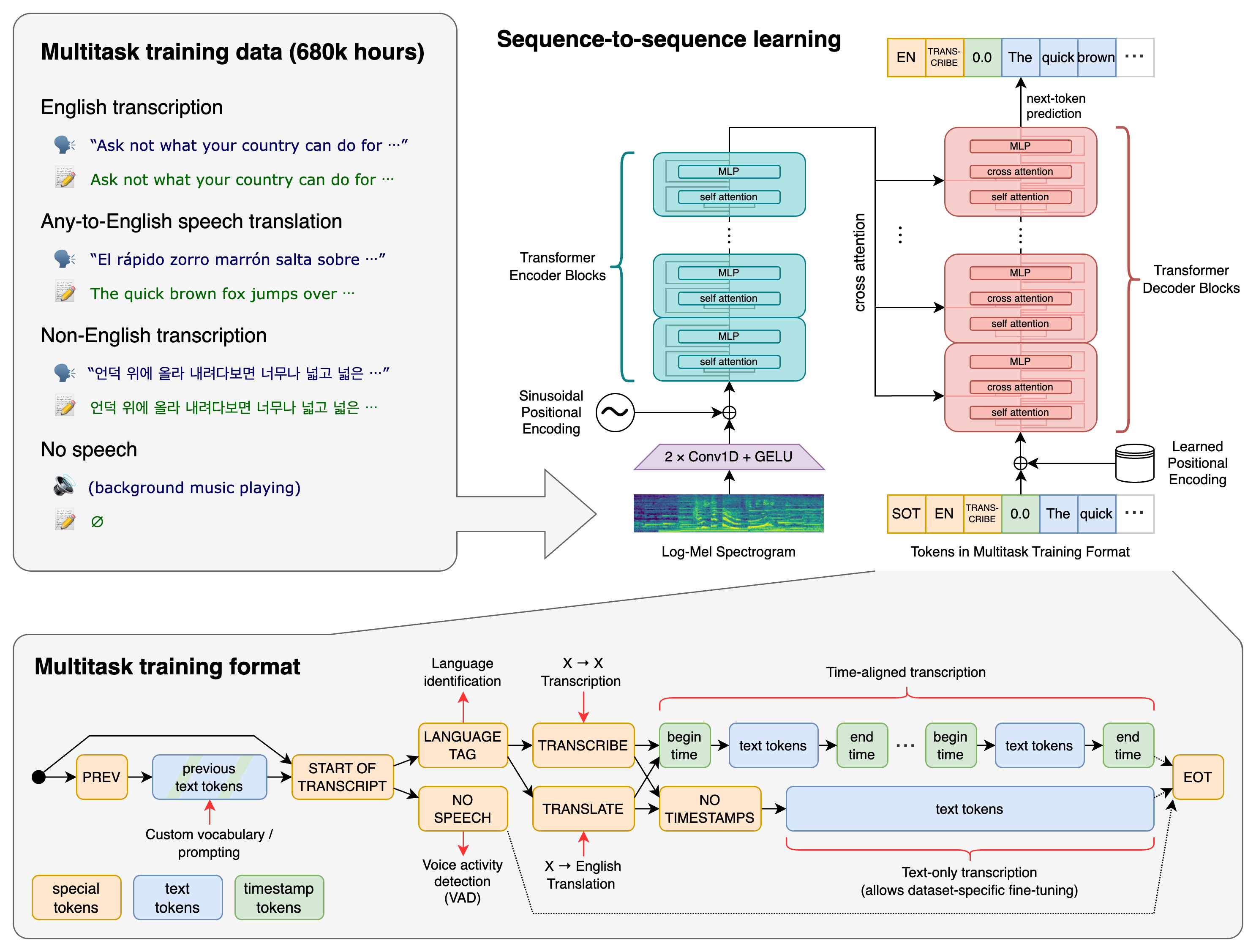

Hace poco vi esta interesante charla filosófica sobre la Inteligencia Artificial impartida por Ernesto Castro y compartida con un vídeo en YouTube. Me pareció interesante transcribir su contenido usando precisamente una IA. En este caso Whisper de OpenAI. También comparto el vídeo original. He hecho algunos retoques sobre todo para que sea más legible. Al final comparto el código Python que he usado.

¿Las inteligencias artificiales tienen derechos?

Pues muchas gracias Alberto por la amable presentación, muchas gracias a todos ustedes por estar aquí, es un placer estar aquí en la Universidad de Castilla y La Mancha dando esta conferencia que se titula Hacia una ética virtual, ¿Tienen derechos los algoritmos? Quisiera para empezar que se fijaran en este vídeo que les estoy aquí proyectando, esta es una instalación que se estrenó en la Bienal de Venecia en el año 2016 y consiste en un robot que intenta desesperadamente limpiar el suelo de la jaula en la que está encerrado, el título de la pieza es No puedo echarme una mano, I can't help myself, de Sun Yuan y Peng Yu, dos artistas chinos que querían plantear una reflexión sobre la inteligencia artificial, sobre la creación artificial y sobre la relación, en fin, entre la ética, la informática. Como ven se trata de, pues eso, literalmente lo que les he dicho, un robot que intenta de manera desesperada limpiar un suelo que está manchado de sangre y que inevitablemente se vuelve a manchar una y otra vez, en un contexto, como ven, donde hay personas que pasean, otros que hacen fotos, gente que está mirando en otras direcciones, mientras él poco a poco se va desesperando al ver que no puede terminar de limpiar ese suelo siempre ensuciado.

Me parece que es una buena ilustración, una buena imagen para empezar esta clase. Como ven, el robot no hace solamente movimientos funcionales, sino que, en fin, se recrea, a veces se felicita por la limpieza que acaba de hacer, en ocasiones se desespera, como hemos dicho, digamos que imitando la conducta también celebratoria o desesperada del ser humano. Me parece que es una buena ilustración, insisto, para empezar esta conferencia, que tiene como objetivo evaluar los límites de lo que se conoce como la ética algorítmica o la ética virtual, es decir, aquella ética que se preocupa por los dilemas morales surgidos en torno al desarrollo de la inteligencia artificial. Aquí tenemos una inteligencia artificial que desarrolla una tarea fútil, que, en fin, está condenada al fracaso, que es incluso como una figura casi mitológica, una especie de sísifo de silicio que una y otra vez limpia un suelo que se vuelve a manchar. Como ya digo, a mí me parece que es una ilustración muy interesante de la conferencia que vamos a plantear. Podríamos incluso plantear la pregunta inicial de si nosotros consideramos que este es un paciente moral o no, es decir, si este tipo de agente que, como ven, se felicita a sí mismo por haber limpiado determinada parcela de ese suelo es o no es un paciente moral, con independencia si lo consideramos un agente racional, con su sentido del deber y del derecho, desde luego tiene una serie de funciones integradas que él desempeña mejor o peor.

A mí, desde luego, me parece que es muy interesante, desde un punto de vista estético, el hecho de que el robot esté enjaulado y, por lo tanto, planteé la cuestión de la barrera o del límite de demarcación entre lo humano y lo artificial. Desde un punto de vista estético, el hecho de que lo que está limpiando constantemente del suelo sea sangre, pues también…, y esta imagen final, ¿no?, esta imagen final de las personas circulando en torno a él y alimentando, a su vez, otros algoritmos, como son los de las redes sociales, donde se postean decenas de fotos de este algoritmo, a su vez, sufriente, intentando limpiar el suelo, me parecía que le daba, ya digo, un carácter redondo al planteamiento del problema. A saber, ¿tienen derecho los algoritmos?

Esta puede parecer una pregunta un poco absurda y, de hecho, la mayor parte de las personas lo consideran así. Sin embargo, planteado en relación a este ejemplo concreto, puede enriquecerse un poco más. Desde un punto de vista estético, como digo, no es baladí que lo que esté limpiándose sea sangre tirada en el suelo. Se puede, incluso –ya digo–, hacer comparaciones con mitos como el de Sísifo, incluso plantear a qué se dedicarán exactamente los robots cuando hereden la tierra de los seres humanos. Quizás a intentar limpiar los crímenes que condujeron a su misma producción. El robot, además, tiene una suerte de concepto pulcro de limpieza que nos recuerda también a la neurosis de muchos filósofos morales que intentan arreglar el mundo, que intentan limpiar esa sangre que, inevitablemente, ya se ha derramado. El hecho –ya digo– de que esté encerrado y que, en última instancia, esté haciendo el trabajo que va a ser robotizado en los próximos años, los trabajos de así llamados de los cuidados, de la limpieza, pues también pone el problema en su justo foco.

No solamente el tema de los derechos de los algoritmos o de los robots, sino también los derechos de los seres humanos, que van a ser reemplazados por esos algoritmos y esos robots. La pregunta de si tienen los algoritmos derechos, pues seguramente se la planteó…, se la han planteado multitud de particulares en su casa, pero en el ámbito filosófico quien lo formuló, por primera vez, de una manera explícita fue Brian Tomásic, autor de un célebre blog utilitarista antiespecista titulado «Ensayos para reducir el sufrimiento» o «Sobre la reducción del sufrimiento». En ese blog y, posteriormente, en la página web para papers, sobre todo académicos, Archive.org, Brian Tomásic, en el 2014, publicó un artículo titulado «¿Importan moralmente los agentes artificiales de aprendizaje por refuerzo?». Con esta expresión tan larga, «agentes artificiales de aprendizaje por refuerzo», Brian Tomásic se refería básicamente a los algoritmos que, en buena medida, aprenden de su entorno por medio del ensayo del error, por medio del refuerzo condicionado a la manera del perro de Paulov o la paloma de Skinner. Esa filosofía y psicología conductista, que tan despreciada o tan vilipendiada está en el siglo XXI, no obstante, es la base de muchos de los condicionamientos adquiridos no solamente por las inteligencias artificiales, sino por las inteligencias naturales que, por ejemplo, operan en las redes sociales. Como es sabido, estas están construidas sobre modelos de condicionamiento de la conducta muy similares a los del perro de Paulov o la paloma de Skinner.

Los agentes artificiales de aprendizaje por refuerzo, los algoritmos, en última instancia, aprenden como aprendemos nosotros, por medio de la prueba y el error, por medio de acciones que son o bien recompensadas o bien castigadas. Una forma de recompensa y de castigo que no tiene una concreción fenomenológica como la del placer o del sufrimiento que experimentamos nosotros, pero que funcionalmente cumple el mismo papel. La inteligencia artificial, al igual que la inteligencia natural, huye del dolor y busca el placer. Lo que se plantea, habrá en Tomás y que, en el contexto de la filosofía antiespecista, es si debemos ampliar nuestro marco moral más allá de lo que ya está ampliado para estos autores. Les insisto que Brian Tomásic forma parte de una comunidad filosófica antiespecista que considera que los animales son pacientes morales, son sujetos de derechos o, por lo menos, de tratamiento moral, con independencia si creemos en los derechos naturales o no, porque sufren y tienen experiencias de placer o de dolor. Es precisamente esa nociocepción, esa capacidad de experimentar el placer y el sufrimiento lo que concedería, a juicio de muchos antiespecistas, derechos a los animales. Esta es una posición que en filosofía moral se califica habitualmente como sensocentrista, a saber, allí donde hay sensibilidad hay derechos morales o, por lo menos, trato moral. Frente a esa posición sensocentrista, por supuesto, hay otras alternativas. La más conocida en la tradición filosófica podríamos llamarlo el raciocentrismo, es decir, la idea de que no hay derechos ni trato moral más allá de la racionalidad específicamente humana.

Contra esa teoría, los antiespecistas tradicionalmente han expuesto el llamado argumento de los casos límite, es decir, dentro de nuestra comunidad moral realmente existente en el presente hay muchos pacientes morales que no son agentes racionales, pues, empezando por los mismos niños, que tienen la misma o menor capacidad racional que determinados simios o determinados mamíferos de altas capacidades cognitivas. Si la cuestión es planteada por los antiespecistas, es muy sencilla, no existe ningún atributo definitorio al ser humano que no esté en otros seres vivos, animales, en menor o mayor grado. El problema que plantea la inteligencia artificial es si hemos de ampliar nuestra comunidad moral no solamente hacia los agentes racionales o sensibles del ámbito natural, sino también hacia los que están por venir o los que ya están presentes de la comunidad artificial. Pues bien, el argumento de Brian Tomasi, que es que el antiespecismo debería ir más allá del sensocentrismo, no debería tan solo reclamar derechos o trato moral para los agentes y seres sensibles, sino también para los algoritmos. Pues los algoritmos están condicionados y se relacionan con su entorno con estímulos de recompensa y castigo similares a los de la, por ejemplo, dopamina en las redes sociales que experimentamos todos nosotros.

Esto ha sido luego posteriormente expandido, se ha montado todo un movimiento, un movimiento que pueden ustedes consultar en internet en la página web petrol.org, podemos incluso ir ahora mismo a ella, los Aprendedores por Refuerzo, que es la página web principal donde están todas las informaciones, preguntas habituales respondidas sobre este movimiento, que ya tiene seis o siete años de edad y que tiene toda una serie de bibliografías al respecto. Entre ellas, la que más le recomendaría sería este artículo que tienen aquí, «Una defensa de los derechos de las inteligencias artificiales», escrito por Erik Svitsgebel y Mara Garza. Y el argumento es este que les he expuesto, básicamente. «Nosotros no somos otra cosa –dicen estos autores– que algoritmos implantados o implementados en hardware biológico. Es una forma de especismo o de racismo virtual o digital el considerar que ciertos algoritmos implantados en un hardware biológico tienen más derecho o más peso moral que algoritmos implementados en silicio». No podemos presenciar el sufrimiento de los algoritmos, pero este existe y puede que no sea relevante o un problema, desde luego, político de primer orden, pero es algo que los filósofos deberían plantearse. Frente a aquellos que dicen que esto son chorradas, pues la filosofía siempre ha ido por delante, por supuesto, de la agenda política.

Y mucho antes de que cualquier político se planteara la posibilidad de legislar el uso de los animales, por ejemplo, dentro de las farmacéuticas o de toda la industria que requiere de la experimentación con animales, pues ya había filósofos que se preguntaban sobre el trato moral o no de estos agentes o sujetos. ¿Cuál es mi posición un poco acerca de esto? Y perdón por darles ya la respuesta, pero vamos a ir directamente a ello, porque no tiene más tutías. El argumento es muy sencillo. El movimiento antiespecista debería ampliar su comunidad moral para incluir a los algoritmos que, aunque no experimenten sufrimiento en los mismos términos fenomenológicos que nosotros, pues a través de los mecanismos como los de la dopamina, etcétera, se relacionan con su entorno por medio de estímulos y refuerzos muy parecidos a los castigos y recompensas psicológicos que nosotros obtenemos cuando conseguimos o fracasamos en nuestros proyectos. Este es, ya digo, el argumento y la propuesta.

Mi posición es bastante negativa o, digamos, crítica con esta teoría. Me parece que es fundamental en el ámbito ético. O sea, yo soy sesocentrista, creo que la experiencia fenomenológica del placer y del displacer es fundamental, incluso hablaría en términos escolásticos diciendo que el placer y el displacer es un atributo trascendental en la ética, es decir, que allí donde no hay placer o displacer no podemos hablar de trato ético, puede haber un trato ecológico, por ejemplo, pues evidentemente los árboles que están plantados detrás suya tienen una serie de intereses biológicos, tienen un conatus espinocista, un deseo de permanecer objetivamente en el ser y, por supuesto, que al talarlos o al cerrar sus ramas estoy de alguna forma interviniendo en sus intereses. Pero esto no es una cuestión ética, yo no tengo por qué tener un trato ético respecto de este tipo de entes, porque no hay una experiencia fenomenológica del placer y del displacer. Cuando yo le cierro una rama a un árbol, este ni sufre ni padece. Y lo mismo sucede con los algoritmos, los algoritmos pueden aprender de su entorno por medio del castigo, entre comillas, o de la recompensa, también entre comillas, pero ahí no hay ningún tipo de experiencia que pudiéramos asociar trascendentalmente con el campo de la ética. En segundo lugar, hay un argumento pragmático, también un argumento esencialista, a ver, si tratásemos éticamente a los algoritmos, estos dejarían de cumplir su función específica, que es, por medio de redes neuronales, aprender de su entorno y, en principio, hacernos la vida más eficiente, más funcional a nosotros. Y aquí…, esto es un tema que no solamente es un argumento pragmatista o utilitarista, sino que va al corazón de la teoría que está detrás de buena parte de este antiespecismo.

Quizás ustedes conozcan vagamente el debate entre consecuencialistas y la escuela de ontológica en el campo de la ética. Muy rápidamente expuesto, podríamos decir que hay dos grandes familias de filósofos morales, aquellos que consideran que las acciones se justifican en base a los principios –esa es la posición principalmente representada por Kant, quien sostiene en una famosa polémica con Benjamin Constant que uno debe decir la verdad, aunque ello conduzca a la muerte de inocentes–, frente a aquel que cree que los actos morales se justifican por los principios, el principio de «nunca mentirás» o «nunca robarás», hay otra serie de filósofos, que se llaman a sí mismos utilitaristas o consecuencialistas, que consideran que los actos morales se justifican por las consecuencias. Entonces, hay ciertas ocasiones en las que mentir no solamente está permitido, sino que es obligado moralmente, por ejemplo, cuando un asesino te pregunta dónde se esconde su víctima. Casi todo el movimiento antiespecista ha sostenido posiciones de carácter consecuencialista y más en concreto hedonista. Esta es una posición o ética que se hereda desde John Stuart Mill y Jeremy Bentham, una serie de filósofos utilitaristas de finales del siglo XVIII, quienes, considerando justamente que la moral se justifica por las consecuencias, se preguntaron cuáles son esas consecuencias. Es decir, a qué tipo de sujetos debería afectar un acto moral para que este sea contemplado como acto moral y no meramente económico o ecológico, etcétera. Y la conclusión a la que llegaron está en un texto célebre de Jeremy Bentham, que para muchos es el comienzo de la lucha filosófica real en favor de los derechos animales, es que ese sujeto de «derechos» –entre comillas, porque para Jeremy Bentham los derechos son estupideces sobre zancos–, ese sujeto de trato moral es aquel paciente que experimenta placer y displacer. Lo dice en un célebre texto respondiendo a las objeciones a la Revolución francesa. En el momento de la Revolución francesa, pues muchos conservadores decían cómo se va a acometer la insensatez de conceder derechos a la clase trabajadora, lo próximo será concederle derechos a las mujeres. Se consideraba una reducción al absurdo decir si concedes derechos a los trabajadores en algún momento se los vas a tener que conceder también a las mujeres. Jeremy Bentham fue más allá y dijo que habrá una época en la que lo importante no sea si uno es racional o irracional, hombre o mujer, rico o pobre, sino si puede padecer, si puede experimentar placer y displacer. Ese es un argumento que expone ahí, en ese famoso texto Jeremy Bentham, y que se hereda en toda la tradición antiespecista.

Esta tradición, que es una tradición hedonista, es una tradición utilitarista, que considera que el bien y el mal se reducen básicamente al placer y al displacer, es una tradición que tiene muchos problemas con la idea de disciplinar y de sacrificio, la idea de que uno prefiera puntualmente obtener, digamos, padecer, tener cierto displacer para obtener un objetivo a largo plazo. Como ya hemos dicho, si no fueran disciplinados por medio de recompensas y castigos, los algoritmos no cumplirían su función específica. Igual que si no hubiera experimentación con animales, por mínima y controlada moralmente que sea, no habría desarrollo tecnológico y científico. Es la pregunta que podemos plantearnos y es si el saber es un fin en sí mismo y cuántas víctimas puede aplastar a su paso. Es una pregunta que se plantea, por supuesto, en el Fausto, si el deseo de conocimiento y de dominio del mundo, digamos, que legitima este tipo de atropellos a pacientes que inevitablemente se consideran violados como víctimas. Entonces, esta es la principal enseñanza, la principal lección ética que yo os traigo de este debate, a saber que el hedonismo, aunque es una posición filosófica de partida bastante razonable, que considera, insisto, que allí donde no hay placer y displacer no hay ética, no obstante queda muy corta para comprender las razones éticas profundas que nos llevan en ocasiones a realizar ciertos sacrificios, es decir, a experimentar cierto displacer por mor de un fin superior. Reducir el sufrimiento no puede ser la única causa ética en el mundo, por mucho que Brian Tomásic lo cree así.

Es más, los seres humanos, podríamos decir, siguiendo a Mendevirán, creen su propia existencia y la existencia del mundo externo porque el mundo externo les presenta ciertas resistencias, y la experiencia de estar vivo y de ser un sujeto diferenciado del mundo consiste justamente en esforzarse y que el mundo se te resista a tus esfuerzos. Y esto es lo que tendría que decir, digamos, a modo de inicio, pero, bueno, como se me quedaba en muy poquita cosa y creo que la cuestión de la ética algorítmica puede dar más de sí, quería también decirles alguna serie de palabras más acerca, en sentido más amplio, de los debates que ha habido en inteligencia artificial desde un punto de vista moral.

Entonces, lo primero que quisiera decir es lanzar una crítica a la moralización de todos los problemas prácticos en el presente. Bueno, estamos ahora mismo en una lucha dentro de la comunidad filosófica a favor del mantenimiento de una asignatura de ética en la ESO. Como si ustedes me han escuchado hablar sobre esta de particular, sabrán que mi posición es la siguiente. No basta con defender la asignatura de ética en la ESO, sino que hay que ir a la ofensiva reclamando la necesidad de la filosofía en su integridad en la educación secundaria. Es decir, que la filosofía no puede quedar reducida a una alternativa a la religión que moraliza y les dice a los chavales de 12, 13 hasta 15 años qué es lo que deben hacer, cómo se deben comportar. La ética en buena medida ha sido utilizada dentro del entramado institucional y empresarial en el que nos encontramos como una fachada, como un pretexto más.

Igual que existe el pink washing, que es el uso de las causas feministas para darle un lavado de cara a proyectos empresariales que no tienen nada que ver con los derechos de las mujeres, e igual que existe el green washing, que es el lavado de cara a las empresas, pretendiendo ser más ecologistas de lo que son, también podríamos llamar que hay un ethic washing, un lavado ético de cara que hace que las empresas se presenten como muy responsables, muy respetables, porque cumplen una serie de funciones sociales, cuando en realidad lo interesante sería estudiar el comportamiento de dichas empresas y de dichas instituciones desde el punto de vista político y económico. Desde un punto de vista político, en los últimos documentos de la Unión Europea se ha abogado por lo que ellos llaman una inteligencia artificial legal, ética y técnicamente sólida, lo cual se describe en siete requisitos. Debe estar supervisada por los seres humanos, debe ser sólida técnicamente, debe garantizar la privacidad y la gobernanza de datos, debe ser transparente, debe ser equitativa, debe garantizar el bienestar y la responsabilidad.

Bien, de estos siete objetivos, supervisión humana, solidez técnica, privacidad, gobernanza de datos, transparencia, equidad, bienestar y responsabilidad, en realidad el único valor que ha sido contemplado como digno de ser respetado en los ordenamientos y en los códigos éticos acerca de los algoritmos en las redes sociales es el asunto de la privacidad, que a mí me parece un tema muy interesante de estudiar filosóficamente. ¿En qué consiste exactamente el valor de la privacidad?

Bueno, el valor de la privacidad es un valor evidentemente moderno, asociado al desarrollo del sujeto principalmente protestante. Es en la ética calvinista, donde se entiende que los individuos tienen una intimidad con Dios, que en su foro interno conectan directamente con el supremo y que no requieren de confesores, como en la vieja religión católica, sino que ellos mismos, a través de la sola escritura, pueden acceder a la inspiración divina. La privacidad es el derecho a ser dejado solo, el hecho de que uno tiene un espacio privado en el que los demás no penetran y no profundizan. Lo más interesante es que, al mismo tiempo que se aboga por la privacidad, son los mismos agentes, los mismos usuarios de las redes sociales los que, cuando se les deja la libertad de publicitar su privacidad, lo hacen sin ningún tipo de cuidado.

Más que hablar de la importancia de la intimidad, sería interesante estudiar lo que Lacan llamaba la extremidad, es decir, cómo la forma superficial que tenemos de conducirnos dice mucho más de nosotros que esa presunta intimidad que nos guardamos íntimamente. Es decir, que un individuo es mucho más real por su conducta y su comportamiento respecto a los demás que por lo que en su intimidad y en su foro interno cree ser. El asunto es que es evidente que el modelo social e institucional de las redes sociales es el modo de la sociedad de control y de vigilancia. Ya lo dijeron una serie de autores, entre ellos Michel Foucault y Gilles Deleuze, que se estaba produciendo en los años setenta, ochenta, una transición desde lo que ellos llamaban las sociedades disciplinarias a las sociedades de control.

Brevemente explicado, las sociedades disciplinarias son aquellas que pretenden internalizar en el sujeto, en la intimidad, en la privacidad del sujeto, una serie de disciplinas, una serie de conductas que en principio deberían conducirle al bienestar, a la felicidad, a la buena vida. El modelo de la sociedad disciplinaria son una serie de instituciones, como la cárcel, la escuela y la familia. Con la desintegración de estas instituciones no se produce una eliminación de los mecanismos de control. Al contrario, precisamente como el sujeto no está disciplinado internamente debe ser controlado externamente. Por decirlo con una célebre cita de Chesterton, cada cura que quitas vale por diez policías. Una sociedad que va perdiendo mecanismos de disciplina internos, como son la religión, va requiriendo cada vez más de sistemas de control policial o parapolicial. Y, en el fondo, todo el desarrollo de la cultura de la cancelación, los indignados, los ofendiditos, todo este asunto de, en fin, las polémicas, la polarización social e ideológica en las redes sociales, no sino otra forma de esta sociedad de control que para Michel Foucault tenía su máxima encarnación en la idea del panóptico. El panóptico es una idea que está expuesta justamente por el padre del utilitarismo, por Jeremy Bensham, quien pensó que la mejor cárcel era una cárcel en la que los propios encarcelados se vigilaran a sí mismos ante la expectativa de un gran hermano, de un gran ojo central que les estuviera mirando constantemente. No es el hecho de ser vigilado, sino la posibilidad, la potencialidad, la virtualidad de esa vigilancia lo que obliga a la autodisciplina. Es una autodisciplina que ya no está, insisto, internalizada por instituciones como la escuela o la familia, la iglesia o el ejército o la cárcel, sino que se difumina a través de mecanismos blandos de poder, como el de las redes sociales, donde se demuestra, en términos foucaultianos, que el poder no es una cuestión de relación jerárquica de dominados y dominantes, sino que es una cuestión mucho más rizomática, mucho más distribuida.

Entonces, lo que es evidente es que estamos en un entorno tecnoptimista, que considera que a los problemas económicos y sociales del presente se les va a dar una solución tecnológica, que basta con esperar a que los grandes gurús de Silicon Valley o de donde sea se saquen algo de la manga para hacer frente a las enfermedades mentales, el cambio climático e incluso la desigualdad de género. Es una ideología libertaria que piensa eso, justamente, que a mayor libertad de emprendizaje en internet, pues mayor bienestar general. Lo que hemos visto es que la mayor parte de las empresas, sobre todo las cinco grandes –Gafam, Google, Apple, Facebook, Amazon y Microsoft– han estado usando este libertarismo de internet para probar impunemente sus productos sobre los consumidores, haciendo sociología de las buenas. La verdadera sociología ya no se hace, por supuesto, en los departamentos de sociología, la hacen las redes sociales con sus grupos de control, diferenciando claramente a estos vamos a darles esto, a estos vamos a darles lo otro.

Lo interesante no es que se esté violando la privacidad, porque, como dijo Gustavo Bueno de una manera muy certera en una intervención que tuvo en la primera edición de Gran Hermano, la privacidad es un valor protestante –esto es importante señalarlo–, es un valor ficticio asociado a la idea de la comunicación interna con Dios. A Gafam no le interesa tu privacidad, le interesa la forma en la que públicamente te relacionas con otros y cómo esa extremidad expresa tus próximos patrones de conducta, no solamente los tuyos, sino los de personas exactamente como tú. No le interesa realmente a Facebook o a Twitter si te estás acostando con fulano o con mengana, le interesa ver cómo personas que se están acostando con fulanos y menganas beta-operatorios en otros sitios van a poder consumir tal o cual producto. El diseño de interfaces, como ustedes saben, lo que hace es primar la facilidad obligando, por lo tanto, a una cierta opacidad sobre los algoritmos que por debajo operan.

Quizás en este desarrollo de la industria y de la tecnología, de la manipulación del comportamiento en línea y fuera de línea, un año crucial a este respecto fue el año 2016, un año en el que hubo varios escándalos relacionados a las redes sociales, muy señaladamente la victoria de Donald Trump, busteada en las redes sociales por Cambridge Analytica, una empresa que se encargó básicamente de dirigir los votos de un sector de la población a los que le iban suministrando periódicamente informaciones farsas. Lo interesante fue cómo, a partir de las modificaciones del algoritmo, posteriores al escándalo de Cambridge Analytica, ha habido toda una transformación del ecosistema de los medios de comunicación en el presente que ha llevado, por ejemplo, a la desaparición del periodismo viral. Muchos de ustedes se preguntarán qué fue de BuzzFeed, a la manera casi de los poetas de Ubisoft. ¿Qué fue de BuzzFeed? ¿Qué fue de VICE? ¿Qué fue de Playground? ¿Qué fue de estos medios de comunicación que en época estaban copando las redes sociales? Cayeron con Cambridge Analytica. Después del cambio del algoritmo, simplemente desaparecieron. Entonces, este es el asunto principal, como digo.

Aunque se hable de que se va a promover el bienestar, la equidad, la presencia humana y la transparencia, etcétera, en el fondo todo lo que se califica como ética de datos está principalmente preocupada por si esos datos y esos algoritmos van a ser transparentes o no para ciertos expertos o ciertos agentes dentro de determinadas redes sociales. Podríamos hablar incluso de un exceso de datos. Esto se ha visto muy bien, por ejemplo, en el nuevo tipo de biografías que se están escribiendo acerca de aquellos autores que vivieron la época de Internet. Estoy pensando principalmente en las biografías que han salido recientemente acerca de Susan Sontag. Susan Sontag, como muchos sabrán, es una crítica cultural estadounidense, que murió de cáncer, si no estoy mal informado, y que vivió los primeros años del uso de Internet. Con lo cual, de ella, al igual que de muchos intelectuales que están desarrollando su vida en el siglo xxi, tenemos no poca información, sino demasiada información.

De Susan Sontag se mantiene y se hizo incluso una exposición al respecto. El historial de sus búsquedas en Internet. Sabemos exactamente... ¿qué páginas porno consultaba Susan Sontag?, ¿a qué horas respondía a los correos?, ¿qué tipo de productos compraba en el supermercado a distancia?, etcétera, etcétera, etcétera. Y el problema ya no es, insisto, que tengamos poca información acerca de los demás, sino que tenemos un exceso de información que da en muchas ocasiones correlaciones espurias. Si ustedes no conocen la página web, se la recomiendo. De hecho, vamos a ponerla ya directamente. Correlaciones espurias es una página web muy divertida que lo que hace es exponer una serie de correlaciones espurias producidas justamente por los metadatos, esta idea de que podremos finalmente prescindir de las teorías y de los mecanismos explicativos de carácter causal, porque bastará con subir todos los datos a algún tipo de algoritmo y él nos dará la respuesta de lo que debamos hacer en el futuro o de cuáles son las fuerzas causales que mueven el presente.

Pues bien, aquí ven, por ejemplo, que existe una correlación de 99 % entre el número de suicidios por ahorcamiento en Estados Unidos y el presupuesto invertido en ciencia. Claro, por supuesto, esto está creado ad hoc, pero fíjense aquí, el número de películas protagonizadas por Nicolas Cage tiene una correlación del 66 % con el número de personas que se han ahogado en piscinas. Y así, sucesivamente, el número de personas que han muerto envueltas en su cama, en sus bedsheets, en sus sábanas, tiene una correlación de 94 % con la cantidad de queso consumido por año en Estados Unidos. Y así, sucesivamente, el número de margarina consumida con la tasa de divorcios en Maine, etcétera, etcétera, etcétera. A lo que asistimos en el presente, una vez que muchos intelectuales han cejado de la gran teoría y se han entregado a las manos del big data, es a este tipo de correlaciones espurias, a un exceso de datos que conduce a esta algocracia donde los algoritmos parecen haber tomado el poder. Muchos pensarán «pero no todo está tan mal, siempre y cuando no lleguemos a la situación de minority report». Y es cierto que no hemos llegado a una situación donde haya, en fin, detenciones policiales en previsión de crímenes que todavía no se han cometido. O quizás estamos en una suerte de minority report distinto. Muchos de ustedes se acordarán de esa película apocalíptica, Cyberpunk hasta cierto punto, en la que se detenía a personas antes de que cometieran determinado crimen porque se pensaba que iban a cometerlo. Se predecía con una exactitud total que iban a cometer ese crimen. Pero en realidad estamos ante un minority report suave bajo la forma del levantamiento o el cuestionamiento de la presunción de inocencia en las redes sociales.

Todo el debate que ha habido en la última década acerca de la cultura de la cancelación, de la postcensura y de los pajilleros de la indignación no hace sino ponernos ante la cara que esta sociedad de control ya empieza a juzgar preventivamente a sus individuos. Hay muchos, en fin, muchos miedos a la sustitución de los seres humanos en ciertos campos. Sobre todo, hay un miedo a la deshumanización y a la robotización en el campo sexual y en el campo de los llamados cuidados. Un futuro distópico en el que una sociedad deshumanizada tan solo copularía con prostitutas robotizadas o en la que todos estaríamos envejecidos, completamente arrugados, siendo alimentados por robots a nuestro servicio. Este miedo a la sustitución de los seres humanos por los robots en el ámbito de los cuidados, tanto sexuales como médicos, podría llevarnos a plantear una versión diferente del famoso experimento de la habitación china.

Muchos de ustedes conocerán este famoso experimento planteado por John Sheldon, que para muchos es la refutación del programa de la inteligencia artificial, explicado sencillamente y para toda la familia. El proyecto fuerte de la inteligencia artificial es aquel proyecto que considera que la inteligencia humana puede ser replicada artificialmente por algoritmos, por robots, por máquinas, y que cualquier algoritmo, cualquier robot, cualquier máquina que se comporte exactamente como un ser humano, en términos conductistas, es idéntica a un ser humano. Si es indistinguible de un ser humano, entonces es humana. El experimento de la habitación china planteado por John Sheldon lo que viene a exponer es cómo incluso en un algoritmo capaz de replicar exactamente nuestra conducta faltaría el elemento de la conciencia, el elemento cualitativo del darse cuenta de las cosas que tan solo podemos tener los seres conscientes. Es un hard problem, un problema muy difícil, como lo llaman filosoficamente, cuál es la relación de supervivencia, de reducción, de emanación, de emergencia entre la conciencia y el cerebro. Imagínense, dice John Sheldon, una habitación china, una habitación donde hay un casillero de entrada y un casillero de salida. En su interior, hay un señor que no sabe nada de chino, pero dispone de un diccionario por medio del cual es capaz de, en fin, responder a cualquier tipo de mensaje que le aparezca en chino. Si tú le metes un mensaje en chino por una de las ranuras, él te va a responder con otro mensaje por el otro lado. Pues bien, así es como funcionan los algoritmos, tienen un input y tienen un output, y tienen entre medias una función que traduce determinados inputs en determinados outputs. A determinada información, determinada respuesta. Pero no hay ningún ejercicio de comprensión. La pregunta que se plantea es si este señor que no sabe nada de chino, que tan solo tiene un diccionario que le permite traducir determinados kanji o hanzu a determinados hanzu, entiende o no entiende chino. La respuesta intuitiva es que no entiende chino, simplemente para él es un cuento chino lo que está traduciendo de un lado para otro. Pues del mismo modo podríamos pensar…

Imaginemos un contexto, insisto, en el que nosotros ya no tenemos a nuestro alrededor seres humanos que nos cuiden, sino que somos pacientes médicos y sexuales de un conjunto de robots a nuestro servicio. ¿Esos robots o algoritmos pueden preocuparse de nosotros? ¿Pueden inquietarse? ¿Tienen la sorge de la cabalada Heidegger en ser y tiempo? La respuesta tradicional sería que no, que al igual que el hombre que está en la caja china o en la habitación china tiene la apariencia de preocupación, pero en realidad no se preocupan, tan solo son capaces de ocuparse de lo que está sucediendo en el presente.

Y vamos ya al asunto que quizás más les preocupa, que es la amenaza de la sustitución de los puestos de trabajo actuales por algoritmos y por, en fin, robots y máquinas de todo tipo. La teoría tradicional de carácter liberal es que, efectivamente, cuando se produce una ganancia de productividad por medio de la incorporación de bienes de capital, pues el número de trabajadores por planta se reduce. Ahora bien, si la economía general crece lo bastante como para que estas ganancias de productividad se traduzcan en incrementos de la demanda, entonces más individuos consumirán determinado producto y, por tanto, aunque por unidad producida haya menos trabajadores, en global la economía y el sector crecerán. Para producir un solo clavo ya no se necesitarán sesenta personas, sino mejor tan solo media persona, pero como se producirán muchos más clavos y se consumirán mucho más clavos, en el conjunto global habrá mucho más trabajadores dentro del sector. Esta es la teoría tradicional neoclásica que se suele exponer y se suele defender y que más o menos cubre, efectivamente, el desarrollo del capitalismo. Los incrementos de productividad vía incorporación maquinaria no conducen a un desempleo general, sino que van aumentando la riqueza de la economía, por lo tanto la demanda y, por lo tanto, la oferta también de ciertos bienes. Esto es lo que es válido para el ámbito de la automatización clásica, sustituir a un trabajador de la FIAT o de la FIAT por un robot que cumple su misma función.

Podríamos incluso decir que, gracias a la tecnificación y a la mecanización, desaparecen los trabajos más inhumanos o peor pagados y, por lo tanto, incluso se está haciendo un servicio humanitario al privarle a ciertas personas de ciertos trabajos, obligándoles a reorientarse hacia sectores donde se requiera más capital humano y donde, en principio, estarían salarios más elevados. Sin embargo, con la automatización digital nos encontramos con un escenario totalmente distinto, pues, a diferencia de lo que sucedía con las máquinas físicas, los autómatas digitales son muy fáciles de replicar y duplicar, no requieren de una inmersión en capital tan grande. Los efectos, por lo tanto, de la automatización y de la robotización generalizada en el ámbito ya no solamente del sector primario y secundario, sino también del terciario, del ámbito de los cuidados, en fin, de los servicios en sentido amplio, parece que conduce hacia un escenario mucho más ciberpunk y distópico, donde todos estaremos en paro tarde o temprano. Aparentemente, nos dirigimos hacia una sociedad en la que aproximadamente el 50 % de los trabajos actuales serán simplemente sustituidos por máquinas, y habrá, como existe en el día de hoy ya, muy poquitos trabajos técnicamente cualificados. y altamente pagados, y servicios poco cualificados, altamente demandados, pero con salarios literalmente de mierda. Mientras que la calificación intermedia, la posibilidad de trabajar en una fábrica o en una oficina con una cualificación intermedia y con un salario digno, poco a poco se va eliminando.

Nos encontramos, por lo tanto, ante dos alternativas o disyuntivas, por decirlo con la clásica disyunción marxista, socialismo o barbarie, o bien una era de ocio, como la que predecía Keynes para el año 2030, prediciendo una tasa de crecimiento del 1 %, Keynes sostenía que para el año 2030 habría un nivel tal de riqueza que los seres humanos no tendrían por qué seguir trabajando. Pues bien, ya en el presente hemos alcanzado la riqueza que Keynes predijo para el año 2030. Sin embargo, trabajamos, consumimos y estamos obligados a darle a la ruedecita de la máquina capitalista no menos, sino más que en el pasado. Sin embargo, hay todavía tecnotópicos, como Yuval Noah Harari, el autor de Deumodeus, que cree que estamos a las puertas prácticamente de la inmortalización de la especie humana. Después de, en fin, haber conquistado todo el globo, el capitalismo ya tiene como objetivo acabar con el hambre, con las enfermedades, con la guerra e incluso inmortalizarnos en una suerte de dicha eterna. Frente a esta visión tecnoptimista, evidentemente hay que señalar que la economía digital es una economía en la que el ganador se lo lleva todo, el que primero llega primero se queda con todo, donde los activos son intangibles y la economía está perfectamente financializada y puede haber ganancias no solamente sin crear empleo, sino destruyendo incluso empleo. Aquí la categoría que se vuelve más válida es la de Karl Marx cuando hablaba del ejército industrial de reserva. Ahora podríamos hablar incluso de un ejército algorítmico de reserva o un ejército virtual o digital de reserva, que sirve como un grupo, en fin, de consumidores de productos digitales, basura y también, por supuesto, de un público cautivo, listo para ser llamado a través de la propaganda en las redes sociales, que gracias a estar parado presiona la baja sobre los salarios realmente existentes. Lejos de ser un elemento inexplicable por la teoría marxista, el paro es un elemento estructural que el capitalismo produce como, insisto, un ejército industrial de reserva o algorítmico de reserva que presiona sobre los salarios a la baja.

Sin embargo, frente a las visiones –insisto– más optimistas de que estamos ante la era del ocio y que dentro de poco podremos dejar de trabajar, me parece a mí que aquí hay una cuestión ontológica que se relaciona un poco con lo dicho al comienzo de la exposición. El ser humano no puede nunca dejar de trabajar y aquí sería importante diferenciar entre empleo y trabajo. El empleo es lo que, por ejemplo, estoy haciendo yo ahora mismo, pero el trabajo es algo que hacemos constantemente, incluso en términos termodinámicos uno puede dejar de trabajar, uno puede dejar de gastar energía. Hay trabajo cuando estamos cuidando a nuestra familia, hay trabajo incluso cuando estamos durmiendo. Una cosa es el empleo como el trabajo remunerado y otra cosa es el trabajo a secas, que uno no puede dejar de realizar. El ser humano, al igual que el resto de seres que viven y se esfuerzan espinocistamente en sobrevivir y en mantenerse en el ser, no puede dejar de trabajar, no puede dejar de esforzarse y de intentar superar las resistencias que le presenta el mundo. Es inevitable el sufrimiento, el dolor, la disciplina, sin la cual –insisto– ni siquiera existiría el concepto del sujeto y de diferenciado de un mundo allá afuera. Y del mismo modo que el empleo no es igual al trabajo, la remuneración no es lo mismo que el salario. Muchas de las economías digitales actuales, de hecho, se sostienen sobre formas de remuneración no salarial, como es toda la remuneración por vía de visibilidad, prestigio, fama, etcétera.

Por último, quisiera exponerle una serie de cuestiones éticas para divertirles un poco, porque no quería dejar de hablar de Elon Musk y del proyecto, en fin, de eliminar la pobreza y, por supuesto, volver automáticos nuestros coches. Esto es algo que él lleva prometiendo como un profeta en el desierto varios años sin que termine de realizarse. La propuesta es una propuesta que todos ustedes conocen, ¿no? Pues los vehículos serán autónomos y ello, lejos de mejorar el tráfico, lo va a empeorar todavía más, porque la gente consumirá más este tipo de Teslas o de coches automáticos, obligando incluso a cavar túneles debajo de la tierra, muchos más de lo que existen en el presente. Lo más interesante, que yo no tenía ni idea de esto, de las propuestas de Elon Musk es que han replanteado en el ámbito del desarrollo industrial el viejo problema ético del tranvía.

El problema del tranvía es un problema clásico de la filosofía ética y que está engarzada, más o menos, con las famosas tres leyes de la robótica formuladas por Isaac Asimov. Asimov, el célebre autor de ciencia ficción, tiene un texto en el que expone que todo desarrollo robótico racional y moralmente comprometido deberá seguir tres leyes. La primera es que un robot no puede dañar a un ser humano o no puede tampoco permitir que un ser humano sea dañado. La segunda ley es que un robot debe obedecer las órdenes que leen los seres humanos, salvo en el caso de que viole la primera ley. La primera ley es que nunca dañarás a un ser humano. Y la tercera ley es que un robot debe protegerse a sí mismo, siempre y cuando no incumpla la segunda ley, siempre obedecerás a un ser humano, y la primera, nunca dañarás a un ser humano. Lo que a continuación, después de exponer estas tres célebres leyes de la robótica, Isaac Asimov, en su cuento Yo, robot, expone precisamente las contradicciones que surgen, los conflictos que surgen inevitablemente entre estas tres leyes. Igual que hay tres campos de valoración moral, la ética, la moral y la política, que inevitablemente van a entrar en conflicto, un robot con tres leyes como son estas, aunque estén organizadas de manera vertical y de manera claramente jerárquica, inevitablemente va a enfrentarse a ciertos dilemas morales, como, por ejemplo, este dilema que tienen aquí en pantalla. Imaginemos que… Les he puesto la ilustración tradicional del tranvía, pero pueden ustedes imaginarse perfectamente un Tesla navegando por uno de los túneles que quiere cavar Elon Musk en Los Ángeles.

Bien, un Tesla desbocado está a punto de atropellar a cinco personas, ustedes se encuentran al lado de una palanca y pueden desviar el Tesla hacia otra vía, donde en vez de haber cinco personas tan solo hay una. Que levante la mano, ¿cuántos de ustedes accionarían la palanca? Es decir, ¿salvarían a cinco personas redirigiendo el tranvía o el Tesla hacia la vía en la que tan solo hay una persona? ¿Cuántas personas accionarían la palanca? Vale, la mayoría. El ejemplo sigue, el ejemplo del tranvía sigue. Imaginemos que, en vez de estar junto a una palanca, pues uno se encontrase en lo alto de un puente y delante suya hubiera un hombre muy obeso, tan obeso que detendría el tranvía desbocado, sin frenos, o el Tesla en el túnel de Los Ángeles. ¿Cuántos de ustedes empujaría al gordo sobre el puente para evitar que esas cinco personas fueran atropelladas? Aquí hay una persona que empujaría al gordo, se llama tal cual el ejemplo, el Fat Man, ¿no? Entonces, el hombre gordo. ¿La justificación de esta discrepancia acaso no es lo mismo lo que está pasando aquí que lo que está pasando aquí? ¿Acaso, en última instancia, el resultado es que muere una persona y se salvan cinco?

Sí, podrían decir ustedes, pero en el fondo, como son tomistas y son escolásticos, ustedes creen, aunque no lo sepan, en la doctrina de doble efecto. La doctrina de doble efecto es que un acto moral puede tener dos consecuencias o más distintas y que lo importante no son las consecuencias laterales de la acción, sino la consecuencia intencionada y causalmente producida. Hay una diferencia, dice santo Tomás, y dice con él buena parte de la tradición escolástica y buena parte también de la tradición analítica, hay una diferencia entre hacer y dejar hacer. No es lo mismo permitir que otra persona mate a un niño que pegarle tú directamente el tiro. No es lo mismo desviar un tren y permitir oblicuamente, como un accidente, como algo no intencionado ni buscado, que muera una persona en otro carril, que tú mismo ser el que empujas a la persona en el carril. Las personas que no han levantado la mano en ninguno de los ejemplos, pues probablemente tengan una visión más, qué sé yo, determinista de la vida, estos cinco tipos están condenados a morir, yo me voy a lavar las manos, no voy ni a accionar la palanca ni a empujar al hombre obeso sobre las vías. Como digo, el argumento es un argumento que no es consecuencialista, porque la consecuencia de la acción es la misma en ambos casos, sino que se sostiene en un principio más elemental. Es decir, cuando uno acciona una palanca, la intención primera, el efecto deseado y buscado es salvar a cinco personas, mientras que la muerte de esta persona que está en la otra vía no es un mero instrumento, tú no estás privándole de su dignidad, sino que simplemente es una consecuencia lateral indeseada, igual que es una consecuencia lateral indeseada que, para terminar con la Segunda Guerra Mundial, pues hubiera que bombardear a Japón con las bombas atómicas produciendo todos los muertos. Los muertos no eran ni un instrumento ni tampoco el objetivo buscado por los militares estadounidenses. el objetivo era acabar con la Segunda Guerra Mundial. Mientras que en el segundo caso ya no puede uno decir que simplemente la intención primera era salvar a las personas. Pues como medio necesario para llegar a ese fin está el empujar y privar dignidad a la persona. Aquí sí se está utilizando a una persona como instrumento para salvar a otras cinco, mientras que en el primer ejemplo, en el ejemplo puro del tranvía, es simplemente una consecuencia lateral indeseada, la diferencia entre un medio necesario y una consecuencia lateral indeseada.

Pero aquí ya llega el tercer caso. El tercer caso es el caso del loop. Esto está mal dibujado porque en realidad la persona que debería estar en la vía menos transitada o menos popular debería ser el hombre gordo. Entonces, esta es una combinación de los dos previos. Usted está al lado de una palanca que puede desviar un tranvía hacia una vía paralela que conecta en una forma de loop con la vía principal, no obstante la persona que está ahí atada es una persona obesa que detendrá el tranvía. ¿Cuántos de ustedes piensan que el que está en este lado de la vía es el hombre gordo, es decir, que no va a volver y a matar a los seis por completo? ¿Cuántos de ustedes, expuestos en esta situación, apoyaría la palanca, que levante la mano? Otra vez todos. Pero se fijan que aquí ya no uno puede agarrarse a la explicación tomista de los dos efectos o del uso no instrumental del efecto colateral indeseado, porque aquí, al desviar el tranvía, el individuo no está simplemente en una vía colateral, sino que está siendo el medio necesario para la detención del tranvía o del Tesla desbocado en un túnel de Los Ángeles. Bueno, pues estos son los tipos… Aunque parezca que esto no tiene nada que ver con Elon Musk y Tesla, la cuestión del desarrollo moral de los coches automáticos tiene que ver con esto. Expuesto en la situación de tener que atropellar a cinco personas o a una, cómo implementar una serie, en fin, de criterios morales en la conducción automática de estos coches para no conducir a un atropello generalizado. Y ya con esto podemos ir cerrando, junto con la idea de una automación mecanizada o totalmente privada de responsabilidad humana.

También hay muchos debates acerca del armamento autónomo, que le quita responsabilidad a los ejércitos, que convierte la ejecución sumaria por medio de drones en algo prácticamente ludológico, relacionado con los videojuegos. Pero quizás lo más interesante sería ya acercarnos al final para hablar de la singularidad. La singularidad es un término que utilizan muchos tecnooptimistas para referirse a aquel momento en que la inteligencia artificial se desarrolla hasta el punto de que supere nuestras capacidades de producción de nuevas inteligencias. Si dentro del conjunto de actividades que hacemos inteligentemente también se encuentra la producción de inteligencias artificiales, se plantean muchos tecnooptimistas, habrá algún momento en que la inteligencia artificial sea lo bastante lista como para mejorarse a sí misma. A partir de ese momento, dicen muchos, el ser humano habría producido su último gran invento. Ya no sería necesario ningún tipo de inventiva humana, pues la propia inteligencia artificial se mejoraría a sí mismo exponencialmente cada vez más. Ese sería el verdadero momento en el que surgiría una superinteligencia que se apoderaría del mundo, una máquina ultrainteligente capaz de diseñarse a sí misma cada vez mejor. Aquí hay dos visiones, por supuesto. La visión optimista, que dice que esto nos va a dar, insisto, la era del ocio, de la vida buena, ya serán las máquinas las que se produzcan a sí mismas y las que se mejoren a sí mismas y se arreglan a sí mismas, y las visiones, por supuesto, ciberpunk o pesimistas, que consideran que esto va a ser la extinción de la especie humana.

Yo simplemente quisiera constatarles que todo esto es futurismo del malo, igual que el que existe en Regreso al futuro, del año 1985. Si recuerdan ustedes, en esa película se predice que para el año 2015 habrá coches voladores y patinetes que no son capaces de ir por encima del agua. En la revista del MIT, del Instituto de Tecnología de Massachusetts, como motivo del cumplimiento de esta predicción fallida en el año 2015, Bush Aldrin, uno de los astronautas que pisó la Luna, hizo unas declaraciones muy sonadas, cuyo titular fue el siguiente. «Me prometieron colonias en Marte y, a cambio, tengo Facebook». Esto es para que se fijen ustedes de la veraspersimilitud que se puede proyectar sobre estas predicciones a futuro. Les recuerdo que en los años ochenta se pensaba que ya en esta década habría coches voladores y patinetes y que habría colonias en Marte. Lejos de estar en la época de mayor desarrollo tecnológico, estamos en una época de rendimientos decrecientes. No hubo mayor transformación tecnológica que la que tuvo lugar entre los años 1880 y 1920. En esos cuarenta años una persona pasó de tener una esperanza de vida de cuarenta años a casi ochenta gracias a la inserción de la penicilina, del UVC, la aparición de tecnologías como el coche, el avión, la radio, el cine, etcétera. Sin embargo, ¿cuáles han sido las tecnologías introducidas desde los años ochenta hasta ahora, en este mismo periodo de cuarenta años? Yo tan solo sería capaz de decirles una, justamente Internet. Pero, claro, ante la expectativa de tener colonias en Marte, que lo que tengamos sea realmente Twitter y Facebook, pues pone todo este tipo de expectativas de superinteligencias y de singularidades a la altura del betún. Estamos hablando de que estos tipos hablan de descargar nuestras conciencias en Internet, mientras que la medida tecnológicamente más puntera para frenar una pandemia global ha sido decirle a la gente que se lave las manos y se ponga un trozo de papel delante de la boca.

Este es el contexto en el que nos encontramos, donde los gurús nos hablan de que vamos a ser iguales a los entes de silicio, mientras las medidas que se utilizan para solucionar los problemas del presente siguen siendo tan rudimentarias como en el siglo XVI o en el XVII. Entonces, esto es lo que yo terminaría diciéndoles. Que no se preocupen por esto, o sea, ya saben cómo es la filosofía, ¿no? Después de una hora charlando yo simplemente les diría «esto no vale nada». Entonces, sin más dilación, les doy la palabra. Muchas gracias.

Código

from pathlib import Path

import os

import openai

import ffmpeg

from yt_dlp import YoutubeDL

openai.api_key = "[OPENAI-API-KEY]"

def download_talk(url: str):

opts = {

"format": "m4a/bestaudio/best",

"postprocessors": [{

"key": "FFmpegExtractAudio",

"preferredcodec": "m4a",

}]

}

with YoutubeDL(opts) as ydl:

ydl.download([url])

def segment_talk(filename: str):

ffmpeg.input(filename).output("output_%03d.m4a", f="segment", segment_time="600").run()

def transcript_talk(glob: str):

path = Path(".")

for filename in sorted(path.glob(glob)):

with open(filename, "rb") as f:

print(filename)

transcript = openai.Audio.transcribe("whisper-1", f, language="es")["text"]

with open("transcript.txt", "a") as f:

f.write(transcript)

f.write("\n")

def main():

download_talk("https://www.youtube.com/watch?v=0_8hsdF_Vd8")

segment_talk("Las inteligencias artificiales tienen derechos.m4a")

transcript_talk("output_*.m4a")

if __name__ == "__main__":

main()